Intelligence artificielle et ESS : régulations, résistances et vigilances

Retranscription de l’intervention de Valérie Peugeot, chercheuse et militante associative, spécialiste des questions de société liées au numérique, dans le cadre de la séance du Conseil d’orientation du Labo de l’ESS du 16 octobre 2025.

Pour contribuer au débat sur le rapport de l’économie sociale et solidaire (ESS) à l’intelligence artificielle (IA), cet article propose une réflexion articulée en trois temps : la présentation des approches de régulations existantes, la place possible de l’ESS dans ce contexte d’un « capitalisme de l’extrême » et les points de vigilance pour l’avenir.

Ce décryptage peut aussi être téléchargé au format PDF ici

Quelles régulations ? Les trois approches possibles du droit.

La régulation internationale de l’IA la plus avancée à ce jour demeure le Règlement européen sur l’IA (RIA ou AI Act) adopté en juin 2024[1]. Pour saisir son ambition et sa portée, il convient tout d’abord de décrire les trois approches cumulatives possibles de la régulation par le droit : l’auto-régulation, l’approche par les droits fondamentaux et celle par les risques.

L’approche par l’auto-régulation consiste à mettre en avant les questions d'éthique autour des principes de responsabilité, de transparence, de vigilance, d’équité. Elle est généralement promue par les acteurs du marché qui privilégient la co-construction de régulations sans intervention du législateur. Ces pratiques ont fleuri en amont de l'adoption du RIA et en l’espace de quelques années, plus de 400 textes, chartes, codes de conduite ont été portés par toute une série de consortiums d’entreprises, des collectifs, des réseaux. Cette approche présente incontestablement l’avantage de la souplesse et de l’évolutivité face à l’innovation technologique de rupture, tout en permettant une intégration progressive dans un système juridique plus normatif. En regard, sa limite principale tient à l'« ethic washing » : il n’existe que peu de moyens de vérifier que les entreprises se conforment à leurs engagements, dénués de sanctions en cas de non-respect. De plus, dans le cas d’un certain nombre de systèmes d’IA, notamment les LLM[2], l'exigence d’explicabilité souvent prônée est en réalité techniquement quasi impossible à respecter. Malgré les avancées de la recherche, même les équipes qui conçoivent ces programmes produisant des résultats par des cascades d’étapes internes, peinent à expliquer les raisonnements exacts qui sous-tendent les résultats obtenus, rendant tout objectif de transparence difficile à atteindre. Finalement, l’autorégulation sert plus souvent à freiner ou empêcher l’acteur public d’intervenir qu’à véritablement répondre à des problématiques associées à ces technologies.

La deuxième approche s’appuie sur les droits fondamentaux. Elle inspire pour partie le Règlement Général de Protection des Données (RGPD), qui accorde un certain nombre de droits aux individus (droit d’accès et de rectification à ses données, droit à l’information, à la portabilité etc.). En l’espèce, ce texte vise la protection des données à caractère personnel, inspiré par les grands principes fondamentaux de la protection de la vie privée. Cette approche par les droits fondamentaux entend donner un pouvoir supplémentaire à l'individu, contribuant à une forme « d'autodétermination informationnelle », responsabilisant les producteurs de données en cas de violation. Mais ce pouvoir ne peut s’exercer qu’en « aval », la vérification du respect du droit comme le déclenchement de sanctions ne se faisant qu’a posteriori du manquement. Cette approche permet d’intégrer une vision éthique dans le droit, elle est « universalisable » et a fait par le passé la preuve de sa robustesse. Le droit de la protection des données à caractère personnel, pour reprendre cet exemple, remonte ainsi à 1978 et n’a connu que deux adaptations majeures depuis lors. En revanche, cette approche est souvent critiquée pour sa rigidité, pour la difficulté à constater les manquements réels aux droits fondamentaux, le plus souvent en l’absence de perception par l’individu concerné et pour la responsabilité qu’il fait peser sur l’individu, notamment via le consentement, dans un contexte d’asymétrie de pouvoir entre celui-ci et les big techs.

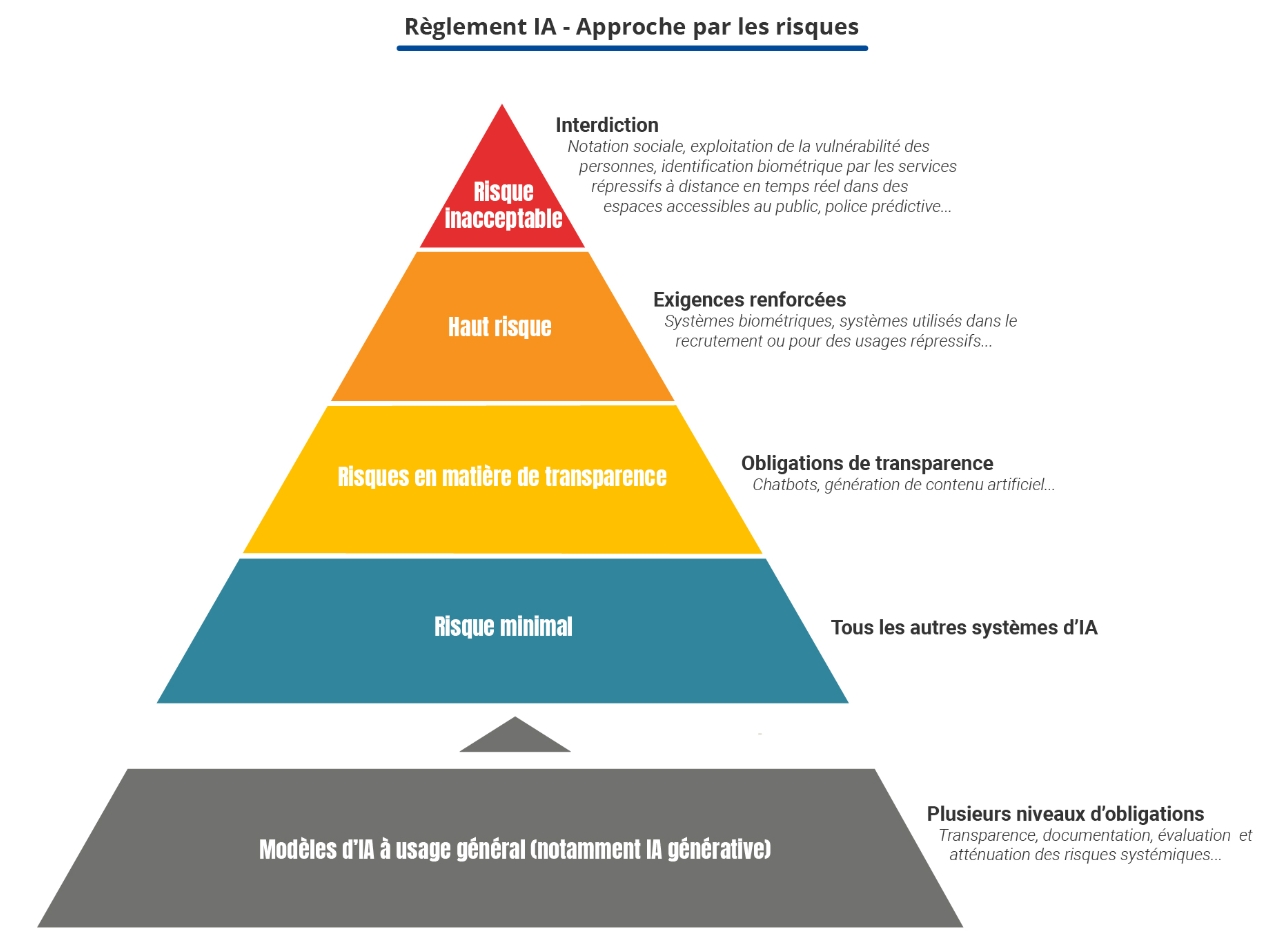

La troisième approche, largement influencée par l’analyse économique, répandue dans le monde anglo-saxon et mise en œuvre dans le droit de l’environnement ou la régulation des marchés financiers, est l’approche par les risques. Partant du principe de l’absence de risque zéro, elle revient à hiérarchiser les risques identifiables en s’appuyant sur la science. Sans conférer de droit aux individus, elle responsabilise les acteurs en amont, dans la conception et la diffusion des modèles d’IA. Cette intention est au cœur du RIA : responsabiliser les acteurs, de la conception à la diffusion, en leur demandant de mettre en place des garanties d’évitement des risques majeurs. Centrée sur les produits et services, et leur sécurité, elle est a priori assez flexible et évolutive, la hiérarchie des risques pouvant être réévaluée régulièrement.

En l'occurrence, la manière dont la Commission européenne a construit sa pyramide des risques (voir ci-dessous le modèle réalisé par klark.ai) au sein du RIA demeure opaque. Elle apparait fondée non pas sur une évaluation scientifique du degré de dangerosité mais est le fruit de négociations politiques avec le Parlement européen et les gouvernements. Elle prohibe par exemple la notation sociale, comme elle peut exister dans certaines villes chinoises, pose des exigences lourdes vis-à-vis des systèmes d’IA dits « à hauts risques » (ex : d’identification biométrique à distance, évaluation des acquis d’apprentissage) avant de décrire des obligations de simple transparence pour des systèmes à risque intermédiaire (ex : chatbots), et ne régule par les systèmes à risque minimal (ex : un outil de traduction automatique). Enfin, le bas de la pyramide est constitué des modèles d'IA qui constituent les fondements au-dessus desquels tournent les systèmes d’IA (ex : le système ChatGPT s’appuie sur le modèle GPT5). Les modèles d'IA sont l'objet d'une réglementation spécifique et même d'une sur-réglementation pour ceux qualifiés de « modèle à risque systémique », c'est-à-dire des risques vraiment majeurs pour nos sociétés (ex : effets négatifs réels ou raisonnablement prévisibles sur la santé publique, la sûreté, la sécurité publique, les droits fondamentaux).

Même si cette approche par les risques est au cœur du dispositif, il fait également la part belle au droit dit souple avec l’instauration de codes de bonnes pratiques élaborés avec l'écosystème des acteurs par le Bureau européen de l’IA (instance au sein de la Commission européenne qui gère le RIA), moyennant une adhésion volontaire des acteurs du marché. Par ailleurs, les secteurs eux-mêmes peuvent en complément élaborer des codes de conduite pour l’usage de leur propre filière[3], toujours sur une base volontaire. En synthèse, l’Union européenne a choisi pour le RIA d’hybrider approche par les risques et droit souple.

Quel rôle pour l’ESS dans ce capitalisme de l’extrême ?

Il convient de parler ici de capitalisme de l'extrême tant les capitalisations des entreprises de l’IA dépassent tous les montants connus jusqu’alors, conjuguées à une hyper concentration à la fois capitalistique, mais aussi géographique des acteurs (Etats-Unis et Chine), voire politique avec la collusion assumée aux Etats-Unis entre tech et pouvoir.

C’est une rupture qui s’impose à nous, et face à laquelle l’ESS – pour ses acteurs qui font le choix d’utiliser l’IA - peut envisager de résister de deux manières : par la commande et par les usages.

Dans son dernier ouvrage, « Pris dans la toile », Sébastien Broca[4], propose une analyse historique considérant tous les mouvements du logiciel libre ou open source et des communs numériques comme complices involontaires des big techs. Il soutient que les principales « alternatives » numériques se sont développées en symbiose avec ces entreprises et les ont in fine aidées à croître, tout en voulant les combattre.

Pour ma part, je maintiens que l'usage de solutions open source reste positive du point de vue de l'ESS, lorsque les acteurs font le choix de solutions comme Hugging Face ou PyTorch. Ces systèmes d’IA open source permettent d'aller vers plus de transparence, d'éviter plus facilement les biais, les hallucinations, etc. puisqu’ils peuvent être corrigés par de nombreux contributeurs. Ils responsabilisent les développeurs qui savent qu'ils travaillent sous le regard d’un collectif. Ils permettent d'avoir des outils plus adaptables aux besoins exprimés et d’aller vers des approches collaboratives innovantes et indépendantes secteur marchand. Enfin, au lieu de contribuer à la course à une IA générale[5] extrêmement énergivore, ces systèmes ont des objectifs plus limités et par conséquent plus frugaux. Quant à la crainte que ces systèmes ouverts ne fassent le jeu des big techs, on constate qu’actuellement les acteurs majeurs de l’IA (Open Ai qui n’a d’ouvert que le nom, Anthropic etc.) investissent massivement dans des modèles propriétaires.

Les acteurs de l'ESS peuvent aussi faire le choix volontaire d’utiliser des outils européens, dans une optique de souveraineté, ou – terme qui me semble plus judicieux – d’autonomie stratégique européenne. Certaines solutions européennes, sans être open source, participent en effet à une forme d'autonomie à l’égard des États-Unis oude la Chine : Aleph alpha, Mistral AI.

Notons enfin qu’en France, toute une démarche a aussi été mise en place, impulsée par le gouvernement au moment du sommet de l'IA, pour établir un référentiel général de l'IA frugale. Si cette intention est louable, elle relève à ce jour plutôt du champ de la recherche et des intentions que de la réalité… Cela étant, les acteurs de l'ESS ont la responsabilité de rester en veille sur l'évolution de cette IA frugale, afin d’être en capacité de bifurquer pour utiliser ce genre d'outil lorsqu’il sera disponible.

Mais l'IA sans données n'est rien. Or, aujourd’hui, les modèles d’IA, invoquant en Europe une exception au droit d’auteur dite « text and data minnig » et s’appuyant aux États-Unis sur le « fair use », s’entrainent à partir des données accessibles en ligne qu’ils aspirent massivement, que celles-ci soient libre de droit ou soumises au droit d’auteur.

Prenant le contre-pied, certains acteurs venus du libre et des communs font le choix de développer des communs de données pour entraîner les modèles open source.

Notons quelques initiatives intéressantes de ce point de vue :

- Common Voice, initiative de la Fondation Mozilla qui développe une base de données libre, accessible sans coûts ni restriction, destinée à la reconnaissance automatique de la parole, grâce à des enregistrements volontaires de voix humaines du monde entier dans différentes langues. Cela permet d’éviter certains biais de genre ou de minorité, et encourage l’usage d’une multiplicité de langues par des développeurs pour leurs applications de reconnaissance vocale ;

- La Large-scale Artificial Intelligence Open Network (Laion), organisation à but non lucratif allemande qui crée et diffuse des modèles et des jeux de donnéesd'intelligence artificielle enopen source ;

- Common Corpus, initiative internationale menée par la start-up française Pleias, qui agrège des textes du domaine public en plusieurs langues européennes permettant d’entraîner des modèles d'IA génératives ouverts, tout en respectant les lois régissant les droits d'auteur.

Points de vigilance

L’IA permet incontestablement de gagner en efficacité, notamment en permettant d'exécuter des tâches routinières, répétitives, même si les applications vont en effet bien au-delà de cet usage répandu. Il reste néanmoins plusieurs points de vigilance sur lesquels attirer l’attention :

- Tout d’abord les systèmes s’améliorent mais « hallucinent » encore, ils font encore des erreurs en abondance ; alors que se répand le « shadow AI » (l'utilisation par des employés d'outils et d'applications d'intelligence artificielle sans l'approbation ou la supervision du service informatique de l'organisation), la formation des équipes est indispensable.

- L’usage de l’IA présente un risque indéniable de perte de créativité, d’homogénéisation de la pensée. Y compris dans des usages qui peuvent sembler « techniques », comme des réponses à des demandes de subventions. A terme, toutes les demandes risquent de se ressembler. L’innovation sociale ne se sous-traite pas à une IA !

- Certains usages déjà rependus dans l’ESS sont fondés sur le principe selon lequel l’IA permet de mieux connaître les publics bénéficiaires, et donc d’adapter les réponses à leurs besoins. Certes, mais ne perdons pas de vue que tout rassemblement d’information, de plus en plus précise et complète, notamment concernant des publics extrêmement fragiles, crée des bases de données sensibles, qui ne sont jamais à l’abri de mésusages, de cyberattaques. Alors que le RGPD s'applique, le principe de minimisation doit primer ;

- Les contenus partagés dans les prompts nourrissent les modèles. Au-delà de la question de la confidentialité se pose celle du partage de créativité d’acteurs de l’ESS à des entreprises capitalistiques d’IA ; avons-nous vraiment envie de contribuer même indirectement à leur développement ?

- Les impacts pour l’emploi dans l’ESS. De prime abord, on peut imaginer qu’une IA ne saura remplacer des fonctions de proximité, de soins aux personnes, de création de lien social… pour autant un travail de documentation et d’anticipation reste nécessaire pour identifier les secteurs ou métiers de l’ESS les plus à risque de substitution par le développement de l’IA : une mission pour le Labo de l’ESS ?

[1] La synthèse de ce règlement est disponible en ligne : Règlement (UE) 2024/1689 du Parlement européen et du Conseil...

[2] Le LLM, ou Large Language Model est un type de programme d'intelligence artificielle (IA) capable entre autres de reconnaître et de générer du texte ou d’autres types de données complexes.

[3] Par exemple le secteur de la robotique, de l’IA médicale, etc.

[4] Sébastien Broca : https://www.seuil.com/ouvrage/pris-dans-la-toile-sebastien-broca/9782021572971

[5] Une intelligence artificielle générale (IAG) est une intelligence artificielle capable d'effectuer ou d'apprendre pratiquement n'importe quelle tâche cognitive au moins aussi bien que l'humain. C’est pour l’heure un horizon purement spéculatif.